基金项目:国家重点项目

作者简介:舒小华(1999—),男,硕士研究生,研究领域为视觉测量,发动机结构强度与振动。

1.航天液体动力全国重点实验室,陕西 西安 710100; 2.西安航天动力研究所,陕西 西安 710100

1.National Key Laboratory of Aerospace Liquid Propulsion, Xi'an 710100, China; 2.Xi'an Aerospace Propulsion Institute, Xi'an 710100,China

visual measurement; computer vision; structural displacement; non-contact measurement; application progress

DOI: 10.3969/j.issn.1672-9374.2024.06.003

结构位移响应可以直接反映火箭发动机整机、机架和桥梁等结构的整体刚度,用于各种结构的故障分析、动态响应分析和性能评估等,因此结构位移测量成为结构健康监测、力学试验、结构有限元模型修正的重要环节[1-5]。如何准确、方便、高效地获得结构位移信息成为众多学者研究的焦点,产生了众多结构位移测量方法。

目前测量结构位移的主要方法分为接触式位移测量和非接触式位移测量。其中接触式位移测量通过固定在结构上的位移传感器直接测量结构在不同载荷下的位移,或利用其他类型的接触传感器测得结构的响应信号,通过一定关系间接得到结构的位移响应[6-8]。非接触式结构位移测量一般通过在待测量结构的远端布置数据采集处理系统获得结构的位移响应信息,该方法不与待测物接触、测量灵活方便 [9-12]。

现有的非接触测量方法中,激光多普勒仪虽然测量精度高,但较难实现同一时刻多个测点的同步位移测量,空间分辨率差,且成本高; 而基于全站仪的结构位移测量需要在结构的待测位置布置棱镜,全站仪通过瞄准棱镜后获得结构的位移,该方法采样率低、空间分辨率低,不适用于结构动态位移的实时测量; 基于全球定位的位移测量系统,需要在测量结构安装定位设备,一般适用于大型结构的位移测量,因为该方法的测量精度和采样频率较低,所以在需要获得高频信息的应用场景下,该方法就显得力不从心,同时该方法也较难应用于像火箭发动机机架、管路等小型结构中[11-13]。随着视觉技术的不断发展,计算机性能的不断提升,基于计算机视觉的测量技术不仅具有其他非接触方法共同的优势,还具有高分辨率、无附加质量、对结构无损伤、无需静止参考点等优势而越来越受欢迎,基于计算机视觉的结构位移测量一般过程如图1所示。

图1 基于计算机视觉的结构位移测量框架图

Fig.1 Frame diagram of structure displacement measurement based on computer vision

本文对基于计算机视觉的结构位移测量方法和应用方面的研究工作进行了梳理和总结。首先介绍了视觉测量的基础——相机标定; 其次,总结了基于计算机视觉的结构位移测量主要方法及发展历程; 在此基础之上,介绍了应用计算机视觉方法测量结构位移的一些实际工程应用; 最后,总结了基于计算机视觉测量方法在测量结构位移中存在的挑战,并对基于计算机视觉的结构位移测量技术的发展进行了展望。

在基于计算机视觉的结构位移测量中,需要获得物体在图像中的尺寸或像素坐标与现实物理世界中物体尺寸或世界坐标之间的映射关系,因此一般都需要对使用的相机进行标定。相机标定就是利用已知的二维平面信息及少量三维空间信息或已知的约束关系解析获得物点与对应像点投影关系的过程,以实现图像中各特征几何尺寸、像素坐标与现实世界物体几何尺寸、世界坐标之间的相互转换。在视觉测量与定位、三维重构等任务中具有重要作用,是计算机视觉测量的基础工作。

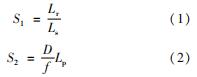

相机标定按照应用场景不同,可分为尺度因子标定和相机模型参数标定两大类。尺度因子标定常用在单目相机二维平面测量中,该标定的目标是确定每个像素尺寸和对应物理空间中尺寸的对应关系。假设相机光轴与被测物体所在平面垂直,对应关系可以由式(1)~式(2)这两种方式确定[14-15]:

式中:S为每个像素对应测量平面的尺寸; Lr为测量表面已知对象的长度; Ls为对应物体在图像中所占的像素数目; D为相机和物体之间的距离; f为焦距; Lp为每个像素的尺寸。但在实际情况下,相机的光轴无法与被测量对象所在平面完全垂直,针对这种情况,文献[14]对式(2)进行修正,得到

式中θ为相机光轴和待测物体所在平面法向矢量之间的夹角。

相机模型参数标定应用在多目相机3D测量、3D点云提取、三维重建等任务中。相机模型参数标定技术主要围绕成像模型与参数标定两大方面展开[16-17]。近些年出现了基于深度学习的相机标定方法、相机自标定方法等[18-20]。但在视觉测量领域,相机的标定一般采用传统经典的标定物标定,仍然从相机模型和参数获取两个方向展开。

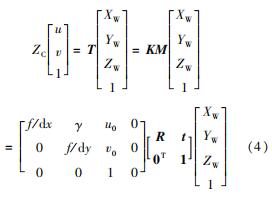

现有的相机成像模型主要分为线性模型、非线性模型和双平面模型。Abdal详细阐述了线性成像模型,其数学模型可表示为[21]

文献[22-23]中详细阐述了引起相机的畸变的原因,并给出了畸变的数学模型。在此基础上给出了非线性模型,其数学表达形式为

与线性模型相比,非线性模型引入了非线性畸变Δu、Δv,其具体表达式为

式中:ZC为尺度因子; K为相机的内参矩阵; M为相机的外参矩阵; R、t分别为相机坐标系相对于世界坐标系的旋转矩阵和平移矢量; [XW,YW,ZW,1]T为世界坐标系下的齐次坐标; [u,v,1]T为像素坐标系下的齐次坐标; k1和k2为径向畸变系数; p1和p2为切向畸变系数。

在相机标定中为了确定上述模型中各个参数,一般需要一些已知信息的标定物。最早采用标定物的相机标定方法是由Abdel-Aziz等提出,采用确定已知相关信息的三维标定物来完成相机标定。其将相机成像过程简化为线性成像模型,标定过程中需要采集到标定物至少两个面上的6个标志点,完成对标志点的匹配后,使用直接线性变换法完成对摄影测量系统的标定,该标定方法计算过程简洁高效,但真实的相机成像模型并非理想的线性模型,故无法保证标定的精度[24]。后来Tsai等[25]先对相机外参进行求解,然后计算相机内参,对相机成像系统中存在的一阶径向畸变进行修正,改善了直接线性变换法标定精度不佳的情况。但是,由于相机标定对标定物的精度要求较高,使得三维标定物的制造成本过高,同时三维标定物存在不便运输、保存等问题,且在对大视场视觉测量系统进行标定过程中,需要使用大尺寸的三维标定物,进一步增加了标定物的加工难度和制造成本。为此,学者在利用二维标定物实现相机标定方面做了大量研究,其中文献[26]提出的标定法是应用最广泛的基于二维标定物信息的相机标定方法,其标定物为平面棋盘格标定板,克服了三维标定物存放困难、加工成本高的问题,采用非线性优化的方法提高了相机标定的精度。之后,众多学者在此基础上提出了改进方法。

特征提取与追踪是视觉测量的关键技术,通过特征提取和追踪确定待测点或区域目标在像素坐标系下坐标变化,结合相机模型和相机标定的结果获得待测目标在现实世界坐标系下的位移改变量或三维坐标。特征提取与追踪的精度直接关系到视觉测量、三维重建等视觉问题求解的质量。

特征提取旨在提取图像中的特征,寻找与目标相关的信息,以便于在不同视角、不同光照条件、不同尺度因子等变化的图像中重新找到这些特征并追踪[27]。常用的特征包括形状特征、边缘特征、灰度特征、特征点特征等,其中特征点应用最为广泛。常用的特征点检测包括:Moraves角点检测[28]、Harris角点检测[29]、Shi-Tomasi角点检测[30]、SUSAN角点检测[31]、FAST角点检测[32]等。Moraves角点检测利用感兴趣点周围4个方向灰度值变化的方差作为响应函数来寻找特征点,但该方法存在对图像旋转敏感的问题; Harris等[29]对Moraves角点检测存在响应函数各向异性、对噪声敏感等缺陷进行改进,提出Harris角点检测,使得Harris角点检测对旋转变化和图像亮度变化具有更好的鲁棒性; Shi-Tomasi角点检测中[30],其在Harris角点检测的基础上对响应函数进行简化,提高了角点检测的稳定性。除了特点特征外,常用的特征检测还包括Sobel算子、Zernike算子、Canny算子、广义霍夫算法等。结构位移测量中,不仅要检测到各种特征,还要确定不同帧中特征的对应关系,确定该关系的方法即目标追踪技术。根据技术特点可以将目标追踪方法划分为模板匹配、特征匹配、光流法这3大类。

模板匹配技术是目标追踪的重要技术手段,基本思路是将追踪目标所在的图像区域作为标准模板,在待追踪图像序列的图像中滑动模板图像,计算每一滑动位置模板图像与待追踪图像区域之间的相似度,将相似度最高的位置作为追踪目标在待追踪图像序列图像中出现的位置,从而实现目标追踪。对于模板匹配中相似度的度量,不同学者提出了不同的度量方法,常见的主要方法可分为模板与图像区域差异和与互相关系数法两类[33-34]。差异和方法中包括绝对差之和(sum of absolute differences, SAD)、平方差之和(sum of squared differences, SSD)、归一化平方差之和(normalized sum of squared differences, NSSD)和零归一化平方差之和(zero-normalized sum of squared differences, ZNSSD); 互相关方法中包括互相关(cross-correlation, CC)、归一化互相关(normalized cross-correlation, NCC)、零归一化互相关(zero-normalized cross-correlation, ZNCC)等,其计算量和抗干扰能力各有特点,可以根据实际任务需求进行选择。但传统的模板匹配方法得到的最佳匹配位置像素坐标往往是整像素坐标,而部分应用特别是视觉测量领域,对追踪的精度要求较高。针对这一问题,不同学者利用不同的方法对匹配过程或结果进行优化,实现了目标的亚像素级追踪。其代表性方法主要包括相关系数曲面拟合[35]、灰度插值[36]、梯度下降[37]等方法,这些方法进一步提高了基于模板匹配方法的目标追踪精度,从而促进了结构位移测量精度的提升。

模板匹配方法的一个典型工程应用就是数字图像相关技术(digital image correlation, DIC),最早由Yamaguchi[38]和Peters等[39]提出。其基本思路是拍摄变形前后两张结构的图像,在变形前的图像中划分一个以目标点为中心的参考子集,然后利用模板匹配的方法追踪该子集在变形后图像中所在的位置,通过标定信息得到该点的位移信息。随着双目视觉技术的发展,将双目视觉技术和DIC技术相结合便可以获得结构表面的三维位移信息[40]。目前,DIC技术已经成为结构变形、力学试验的重要测量手段,很多公司也推出了成熟的商用软件。在DIC技术的基础上,将其向三维方向扩展,发展出了数字体相关技术(digital volume correlation,DVC)[41]。其是一种测量物体内部三维全场变形的先进测量技术,DVC也具备非接触、测量简单方便、抗干扰能力强等视觉测量方法的优点,但DVC需要获取结构内部的特征信息,除一些特殊场景外,一般需要使用特殊的扫描装置。

特征匹配追踪是在特征提取的基础上,确定相同特征在不同帧中的对应关系,得到特征在像素坐标中的位置变化。特征匹配一般涉及特征描述和异常值剔除等工作。常用的特征匹配方法一般通过定义特征向量描述子来对特征进行表达,然后根据特征向量之间的“距离”或搜索方法来进行特征匹配。

常用的特征描述子有SIFT[42],SURF[43]等。图2展示了利用SIFT方法对游机的特征点检测结果。

常用的特征向量距离度量包括汉明距离、欧几里得距离等。常用的异常点剔除方法主要有基于单应性矩阵变换的RANSAC法和LMS法。常见的ORB特征匹配方法就是利用FAST角点检测作为特征点,以BRIEF为描述子,利用汉明距离进行匹配,图3展示了不同帧中特征点的匹配情况。

光流方法也是特征追踪的一种重要方法。光流的概念最早由美国的心理学家Gibson在1950年提出,光流是指空间物体在观察平面上像素运动的瞬时速度[44]。随着摄影技术和计算机视觉的不断发展,20世纪80年代兴起了通过图像序列来计算光流的工作。根据计算的光流结果配合相机标定的结果便可用于测量工作中。通过图像序列计算光流的方法可分为传统方法和基于深度学习的方法。

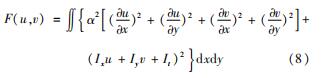

传统光流法的代表经典方法主要有由Horn等提出的HS(Horn-Schunck)光流算法[45]和由Lucas等提出的LK(Lucas-Kanade)光流算法[46]。其中,LK算法是稀疏光流算法,HS算法是稠密光流算法,该算法都基于两条基本假设。①亮度恒定不变假设:同一目标在不同帧间运动时,其亮度不会发生改变。②小位移假设:在相邻两帧之间,同一目标在像素坐标系下变化不会太大。根据以上两条假设可以得到光流法的数学表达为

Ixu+Iyv+It=0 (7)

式中:Ix、Iy分别为亮度对x、y方向的偏导数; It为亮度对时间的导数; u、v分别为像素沿x、y方向的速度。一个像素点只能确定一个等式,该等式有两个未知数,因此式(7)是不定方程,无法直接求解。针对该问题,LK方法引入相邻空间一致性的第三条假设,即在一个小窗口内相邻像素的运动相同,这样便可以通过最小二乘的方法求得该窗口的光流信息。HS方法对式(7)增加了全局平滑的约束条件,建立优化问题的目标函数为式(8),通过迭代优化的方法实现像素点光流的计算。

式中α为平滑系数。

针对LK和HS方法在实际使用中存在的问题,不少学者提出了改进和重构方法。针对LK光流只能处理小位移运动的问题,文献[47]中将图像金字塔应用在LK光流估计中,通过迭代的方法解决了大位移特征点的光流估计问题; 同时为了提高光流估计的精度,应用双线性插值的方法对特征点周围的亮度值进行插值,实现了亚像素精度的光流估计。Farneback[48]提出了Farneback光流估计方法,其假设图像梯度恒定,局部光流恒定,通过多项式展开的方式估计全场稠密光流信息。文献[49-51]在经典光流法的基础上,提出了众多改进算法以克服光照变化对光流估计的影响、保留光流变化的不连续信息,不断提升光流估计的精度。随着深度学习、神经网络的不断发展,特别是卷积神经网络的出现,光流估计逐渐从经典方法向深度学习方向发展。

2015年,Dosovitskiy等[52]提出了FlowNet网络,将CNN网络直接应用于光流预测。其提出的FlowNet分为两个框架,分别为FlowNetSimple网络和FlowNetCorr网络,FlowNetSimple仅由卷积层组成,而FlowNetCorr网络在卷积层的基础之上增加了特征关联层。在自制的数据集Flying Chairs通过监督学习的方法对提出的两个网络分别进行训练,并在不同数据集上进行了验证,结果表明了完全基于卷积神经网络的有监督端到端网络模型具有解决光流预测问题的能力。同时试验结果还表明FlowNetSimple网络模型有更好的泛化能力,而FlowNetCorr网络模型存在较高的过拟合风险。

文献[53]针对FlowNet精度差于一些经典光流方法、无法应用变分的方法计算小位移和现实世界数据中的光流估计困难的问题,提出了FlowNet2.0网络(见图4)。其以FlowNet网络为基础,将多个FlowNetSimple网络和FlowNetCorr进行堆叠组合,并且加入了一个可以提升微小运动光流计算精度和速度的特殊子网络来完成光流计算。该网络在Fling Chair和FlyingThings3D[54]数据集进行训练。为了增强网络的泛化能力,其在训练数据集上通过加入光照变化、背景杂波和其他噪声进行数据增强。同时该方法中采用先Fling Chair,再FlyingThings3D数据的训练顺序,提高网络的光流计算精度。该网络在不同的光流公共数据集上进行了测试,其计算结果相对于FlowNet网络在计算时间稍有增加但计算误差减少了50%。除此之外,众多学者还提出了其他基于监督学习的光流估计网络,基于非监督学习的光流估计网络也在快速发展。

图4 Flownet 2.0网络结构[50]

Fig.4 Net structure of Flownet 2.0[50]

Lai等[55]采用水平布置的相机组成人眼立体视觉系统,通过时间域相邻帧的光流估计和两台相机拍摄得到的图相对的立体匹配获得物体运动的三维信息。其针对之前研究者使用不同的网络估计光流和完成立体匹配不能共享特征表示的问题,提出了一个单一网络同时完成光流估计和立体匹配,并且这两个任务可以共享学习到的特征表示的网络模型。该无监督学习网络模型图如图5所示,采用4部分网络的损失函数(重建损失Lrec、平滑损失Lsm、左右图像对相关一致性损失Llr、2-扭曲一致性损失L2warp)的加权和表示该网络的损失函数。最后在经典KITTI数据集进行了验证,结果表明该网络可以很好地估计场景的光流和深度信息。

基于计算机视觉的结构位移测量技术在工程应用方面,美国航空航天局在2013年7月31日—2013年9月5日J-2X热试车期间,安装了两台相机拍摄发动机待测区域喷涂的散斑,通过3D-DIC技术对燃气发生器出口管和燃料涡轮排气管区域进行了振动位移测量。在复杂的试车台环境下,通过3D-DIC技术成功追踪到发动机在管路充填和预冷后发生了明显的位移变化。在发动机摇摆状态下,获得发动机整体位移的同时得到局部的位移和工程应变信息[56]。

陈凡秀等[57]将3D-DIC技术和多相机同步采集系统同步相结合,以最小化三维空间误差为目标函数,确定各个目标点所对应的最佳双目视觉系统,进而确定目标点的空间三维坐标和位移。并且利用该方法测得镍铬合金不锈钢材料在18~1 000 ℃范围内温度变化引起的材料三维变形,获得加热中心离面位移的最大值为10.285 mm,x、y面内位移较小,得到材料的离面应变场。对得到的温度-热应变结果进行二次多项式拟合,得到镍铬合金不锈钢材料离面方向的膨胀系数。

2020年,杜鹏等[58]将NCC作为相似度度量函数,利用模板匹配的特征追踪方法测得郑州桃花峪黄河公路大桥缩尺寸模型在移动小车载荷和力锤敲击载荷叠加下竖直方向的位移信息,其结果与位移传感器测量的结果误差小于5%。同时,在该视觉结构位移测量中,为了提高计算效率,对采集到的图像序列数据进行了特征点差分处理,仅保留结构关键全息信息,大大提高了匹配效率。与原始方法相比,相同条件下,该方法的效率提高了86.7%。

2024年,高玉闪等[59]通过在发动机机架上粘贴圆形标记点的方式,利用双目视觉测量方法成功测得机架在静力试验中的位移响应信息。该实验中通过椭圆最小二乘拟合的方法,实现了结构位移的亚像素精度测量,该测量结果和传统顶杆式位移计测量结果的最大误差为5.6%,但试验准备时间小于传统位移传感器测量方法。

杜永峰等 [60]采用双目视觉的方案成功测得5层框架振动模型振动台试验中的位移响应信息。 其采用Shi-Tomasi角点检测算法对试验采集的图像序列进行特征点检测,之后利用SIFT描述子对提取的角点特征进行特征描述,利用特征匹配的方法实现左右相机的特征点匹配和前后帧特征点的追踪,结合相机标定信息测得模型在振动试验过程中的三维位移响应信息,离面方向的位移测量结果与传统接触式拉线式位移传感器测量结果的相对误差小于8%。

张晓勤等[61] 针对基于光流法测量河流流速的方法易受试验噪声和成像条件影响的问题,采用融合互相关和光流法相结合的方法来对河流流速进行测量。该方法首先对相机拍摄得到图像序列的相邻帧使用互相关方法来检测相邻帧之间的速度矢量场,然后使用稠密光流法对互相关方法测量得到的速度矢量进行补充,进而得到最终测量的速度矢量。并通过标定好的相机将测量的速度结果映射到真实的物理世界中,将测量结果与水文站测量的结果进行对比,结果表明,通过融合互相关法和光流法相互结合的方法测得的平均流速与水文站测量的误差仅为4.3%。该思路对结构位移测量有很强的借鉴意义。

Gong等[62-63]通过双目立体光流方法对鸟形机翼位移和变形进行了测量。文献[62]针对大位移情况,结合图像金字塔算法,测得雷诺数为105情况下,随着机翼攻角不断增加时机翼的变形情况。其采用非线性结构张量扩散保证光流的不连续性。在公开数据集旋转球序列上验证了改进算法的可行性,并测量了鸟形机翼在风洞中风载作用下的变形情况。其中文献[63]对传统的HS光流法进行了改进,其把传统HS光流法的平滑项惩罚函数由简单的光流梯度的平方和函数改为一个近似一范数的可微Charbonnier惩罚函数,同时,针对原来光流法估计的光流信息在被测物体的边缘差异很大的问题,采用流驱动的各向异性扩散张量代替了原来光流法的平滑项。该方法成功应用在鸟形机翼变形的三维测量中,将测得结果与数值仿真、DIC方法和LK光流法得到的结果进行对比。结果表明,该方法一定程度上增加了稠密光流法的计算速度,保留了不连续突变变形信息。

文献[64]中使用基于深度学习方法的FlowNet2对全场光流进行计算并测量结构的位移响应。其通过一个预先训练好的神经网络来计算光流,得到图片中某一点的像素位移,最后应用相机标定的结果将像素位移转换到真实的物理世界中。对于离散点的位移测量,可以在离散点所在的区域通过使用一个高斯核或者平均核计算该离散点的位移信息。其在中佛罗里达大学结构实验室设计的看台模型上进行了试验验证,将FlowNet2测量的结果与Classic+NL方法和位移传感器测量的结果进行对比,验证FlowNet2光流方法测得结果的准确性。接着对中佛罗里达大学的人行桥结构的位移进行测量,通过直接减去图像中静态区域的运动方法来消除相机运动对测量结果的影响。最后其直接对测量的位移进行FFT变换,得到桥梁的前3阶模态,其中第一阶频率与加速度传感器测量数据分析得到的一阶频率误差为0,二阶误差为0.46%,从而验证了该方法在工程中的可行性。

本文介绍了基于计算机视觉的结构位移测量相关知识,总结了基于计算机视觉的结构位移测量的主要技术发展路线,并对其中具有代表意义的方法、模型的基本思路、创新点、实现效果等进行了概述。在此基础上,选取了一些基于计算机视觉方法测量结构位移的典型案例进行总结。这些案例中包括发动机工程中测量应用,可以预见,具有众多优势的基于计算机视觉的结构位移测量方法未来会大范围应用在液体火箭发动机整机及部件结构位移的测量中。

从技术发展角度来看,基于计算机视觉的结构位移测量方法愈加复杂,不断引入新的模型增加测量的精度和速度。从需求来看,在工程应用中对于结构位移测量的测量精度和测量数据实时性处理的要求不断提高,对测量结果的时间分辨率和空间分辨率不断增加。同时,在基于计算机视觉的结构位移测量方法中,三维结构位移测量方法更受研究者的青睐。

因此,如何通过基于计算机视觉的方法快速、高效、准确、高时间空间分辨率获得结构的三维位移信息将是之后很长一段时间研究的热点。随着深度学习的快速发展,以及各种加速技术的相继出现,基于计算机视觉的结构位移测量方法和深度学习相结合成为了基于计算机视觉的结构位移测量方法的主要发展趋势。首先,深度学习可以实现图像超分辨分析; 同时,深度学习对图像具有强大的洞察能力,这些优势均可以大幅提升基于计算机视觉的结构位移测量精度。其次,随着各种硬件的升级和更加高效加速算法的出现,使得基于计算机视觉的结构位移测量和深度学习相结合可以实现测量的实时性。最后,特大结构、不规则结构、贫纹理结构等复杂场景下的结构位移测量将成为基于计算机视觉结构位移测量的主要领域。而在液体火箭发动机整机及部件的结构位移测量中除了上述工程应用的需求外,还需克服高强声振环境、极端亮度条件对测量精度的影响。实现多相机协同工作,在力学试验及试车场景下的液体火箭发动机全场位移实时测量。